Grok 4 Fast 是什么?

Grok 4 Fast 是 xAI 最新推出的高效推理AI模型,延续 Grok 4 的能力框架,支持 200 万 token 长上下文,在保持强大推理性能的同时平均减少约 40% 的推理 token 消耗,显著降低成本与延迟。模型可统一处理推理与日常对话,并具备浏览器与搜索工具调用能力,能从网页、图像或视频中获取信息,适合开发者、研究者及普通用户在低成本环境下使用,广泛开放于 grok.com、移动端 App 与 API 平台。

Grok 4 Fast 的功能亮点

Grok 4 Fast 采用创新设计,统一了“推理”(reasoning)和“非推理”(non-reasoning)模式到一个单一权重空间中,通过提示引导切换模式。这避免了传统模型的模式切换开销,并端到端训练了工具使用强化学习(RL),提升了代理式任务的效率。 主要亮点包括:

- 超长上下文窗口:支持 2 百万 token 的上下文长度(约 150 万字),远超大多数竞品(如 GPT-4.1 的 100 万 token),适用于处理长文档、复杂代码库或多轮对话。

- 速度提升:响应速度比平均水平快 10 倍以上,输出速度显著优于 Grok 4,同时使用约 40% 更少的“思考 token”(计算资源),实现低延迟推理。

- 多模态支持:继承 Grok 4 的能力,支持文本、图像和工具集成,特别擅长代理式编码(agentic coding)和搜索任务。

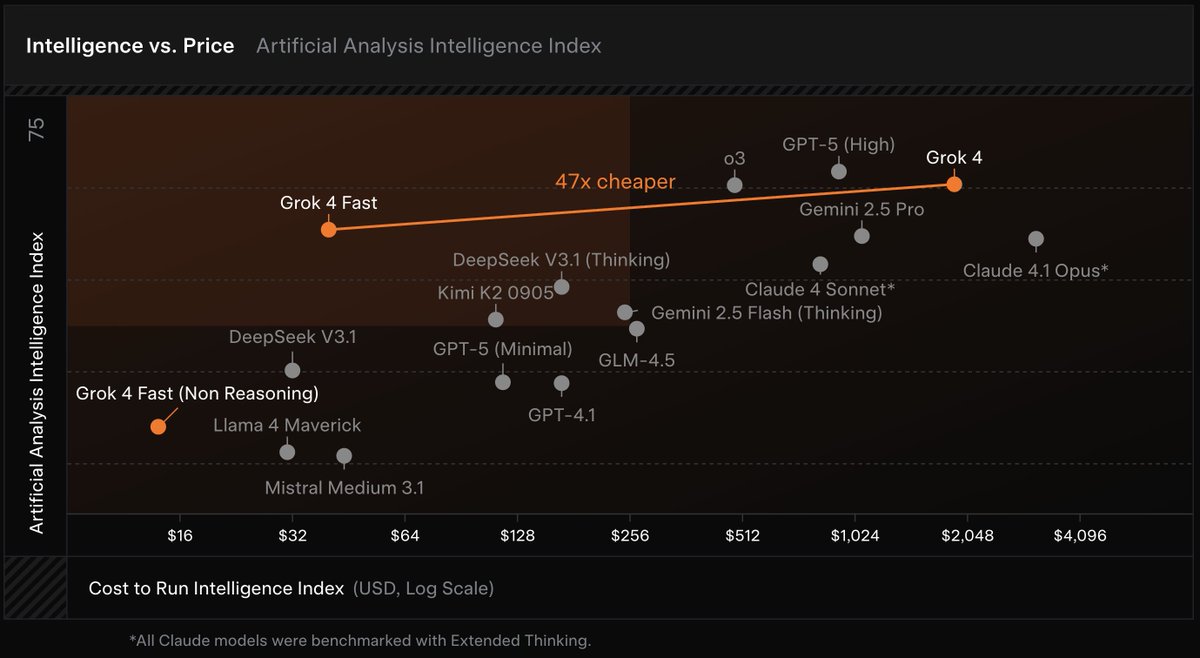

- 成本效率:API 定价极具竞争力,输入 $0.20/百万 token,输出 $0.50/百万 token,被誉为“性价比之王”。 它在保持 Grok 4 性能的同时,计算成本降低 40%,适合开发者大规模部署。

| 特性 | 详情 | 与 Grok 4 对比 |

|---|---|---|

| 上下文窗口 | 2M token | 与 Grok 4 相同,但 Fast 版更高效 |

| 模式 | 统一 reasoning/non-reasoning(提示切换) | Grok 4 需分离模式 |

| 训练方法 | 端到端 RL + 工具使用 | 相同,但 Fast 优化了 token 消耗 |

| 速度 | 10x 更快,40% 少 token | 显著优于标准版 |

| 多模态 | 文本 + 图像 + 代理编码 | 相同 |

| 定价 | $0.20 in / $0.50 out per 1M | 约 47x 更便宜 |

Grok 4 Fast 的性能基准

Grok 4 Fast 在多个基准测试中表现出色:

- 搜索排行榜:位居 #1,代号“menlo”在社区测试中脱颖而出。

- Extended NYT Connections Benchmark:Reasoning 版创下 759 谜题新纪录,击败 OpenAI GPT-5、o3-pro、Google Gemini 2.5 Pro、DeepSeek 和 Qwen 3。

- MCPUniverse Leaderboard:成功率 27.27%(中上水平),但 $/性能比遥遥领先。

- 整体智能:与 Grok 4 相当,甚至在某些任务(如规划和一击解决)优于 Gemini 2.5 Pro,用户反馈其“几乎像人类一样不冷冰冰”。

如何使用Grok 4 Fast

- 平台:可在 grok.com、x.com、Grok iOS/Android App、X iOS/Android App 上访问。X 的免费用户也可直接使用,限时免费。

- API:通过 xAI API 通用可用,短期内于 OpenRouter 和 Vercel AI Gateway 免费提供(限时)。 对于 API 相关查询,请访问 https://x.ai/api 获取详情。

- 订阅:Grok 4 系列(包括 Fast 版)主要面向 SuperGrok 和 PremiumPlus 订阅者,提供更高配额;免费版有使用限额。SuperGrok 定价详情 https://x.ai/grok。 x.com Premium 详见 https://help.x.com/en/using-x/x-premium

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。