LongCat-Flash-Chat是什么

LongCat-Flash-Chat 是美团基于 LongCat-Flash 打造的对话增强大模型,规模达 5600 亿参数,采用 Mixture-of-Experts 架构与动态专家激活机制,兼顾高效推理与长文本处理能力。它在基础模型上经过指令对齐与人类反馈训练,优化了多轮对话、工具调用和智能体(Agent)任务表现,支持最长 128K 上下文输入,已在 Hugging Face 开源,适合研究者、开发者和团队用于智能交互与应用集成。

LongCat-Flash-Chat 的功能特性

- Mixture-of-Experts 架构:采用 5600 亿参数 MoE 设计,平均激活约 270 亿参数,实现高效推理与性能平衡。

- 动态专家激活:按需调用不同专家,提升计算效率,推理速度可超过 100 tokens/秒。

- 长上下文支持:原生支持最长 128K token 输入,适合长文档、多轮对话与复杂任务。

- 对话优化与对齐训练:在基础模型上进行指令调优与人类反馈对齐(RLHF),增强自然对话能力。

- Agent 能力:支持函数调用、多步骤任务执行和工具协作,适合智能体应用开发。

- 开源开放:MIT 协议开源,已在 Hugging Face 提供权重和接口,便于研究与二次开发。

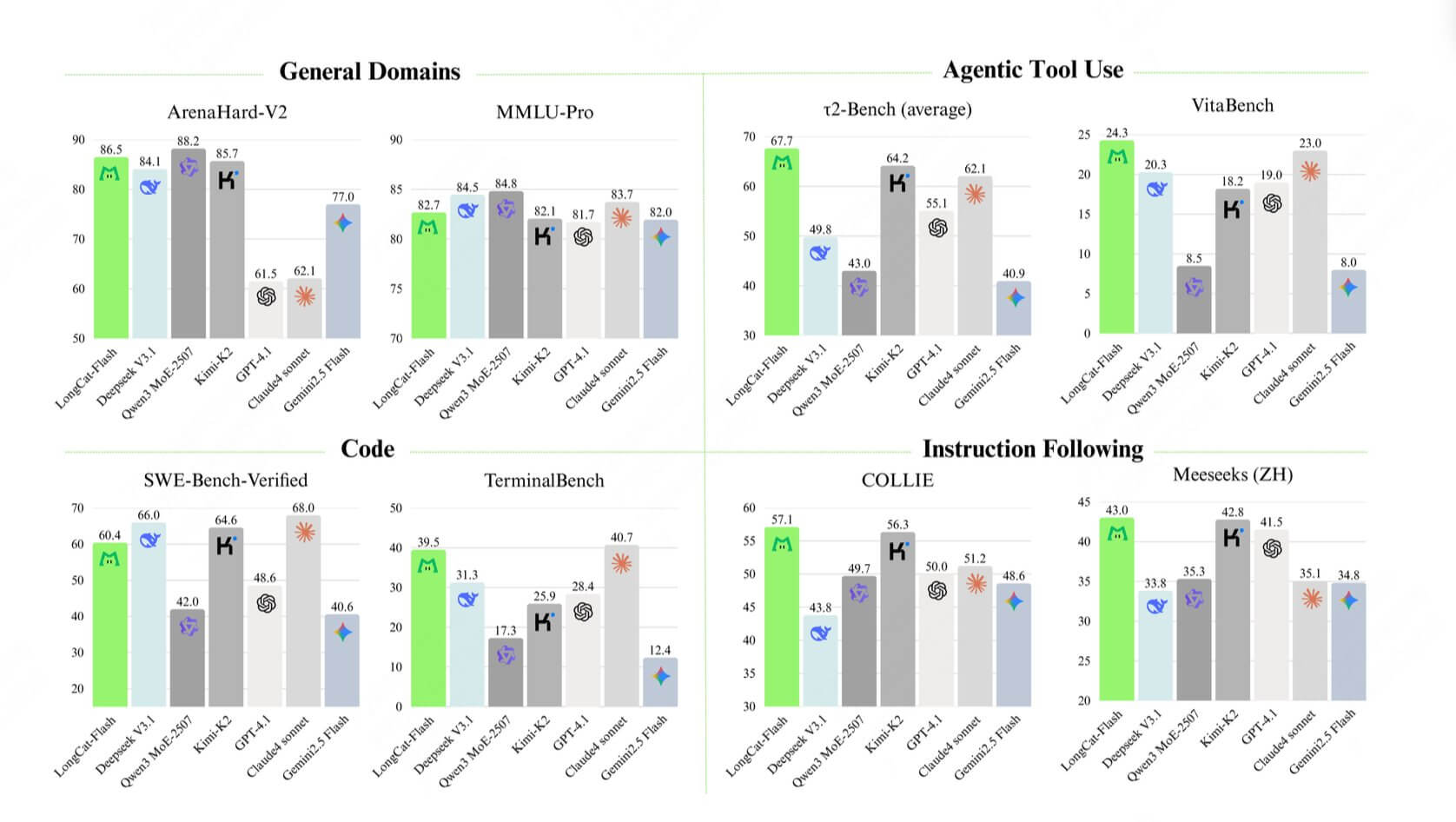

LongCat-Flash-Chat的模型评测

Longcat-Flash在部分benchmark上,比如Agent工具调用、指令遵循的表现超过DeepSeek-V3.1、Qwen3 MoE-2507,甚至比闭源的Claude4 Sonnet还要好。在TerminalBench上,和公认的“编程之王”Claude4 Sonnet不相上下。

LongCat-Flash-Chat 的应用场景

- 智能体(Agent)开发:利用其工具调用、多步骤推理与函数调用能力,构建自动化 Agent 系统。

- 企业应用:可作为智能客服、知识问答、数据分析助手的后端核心模型,支持大规模交互。

- 软件开发与代码助手:帮助开发者进行代码生成、调试、解释与优化。

- 长文本处理:在法律、科研、咨询等场景中处理和总结长文档,支持多轮对话追踪。

- 个人用户探索:通过对话体验模型的自然交互与逻辑推理能力,用于学习和日常问答。

如何体验 LongCat-Flash-Chat

LongCat-Flash-Chat 模型 已在多个平台同步开放,用户既可通过开源代码与权重进行研究和部署,也能直接在线体验模型对话能力:

- 在线体验:longcat.ai —— 网页端直接交互,无需部署

- Hugging Face:huggingface.co/meituan-longcat —— 提供模型权重与调用接口

- GitHub:github.com/meituan-longcat/LongCat-Flash-Chat —— 包含源码、使用示例与部署说明

- 技术报告:tech_report.pdf —— 模型架构与训练方法详解

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。