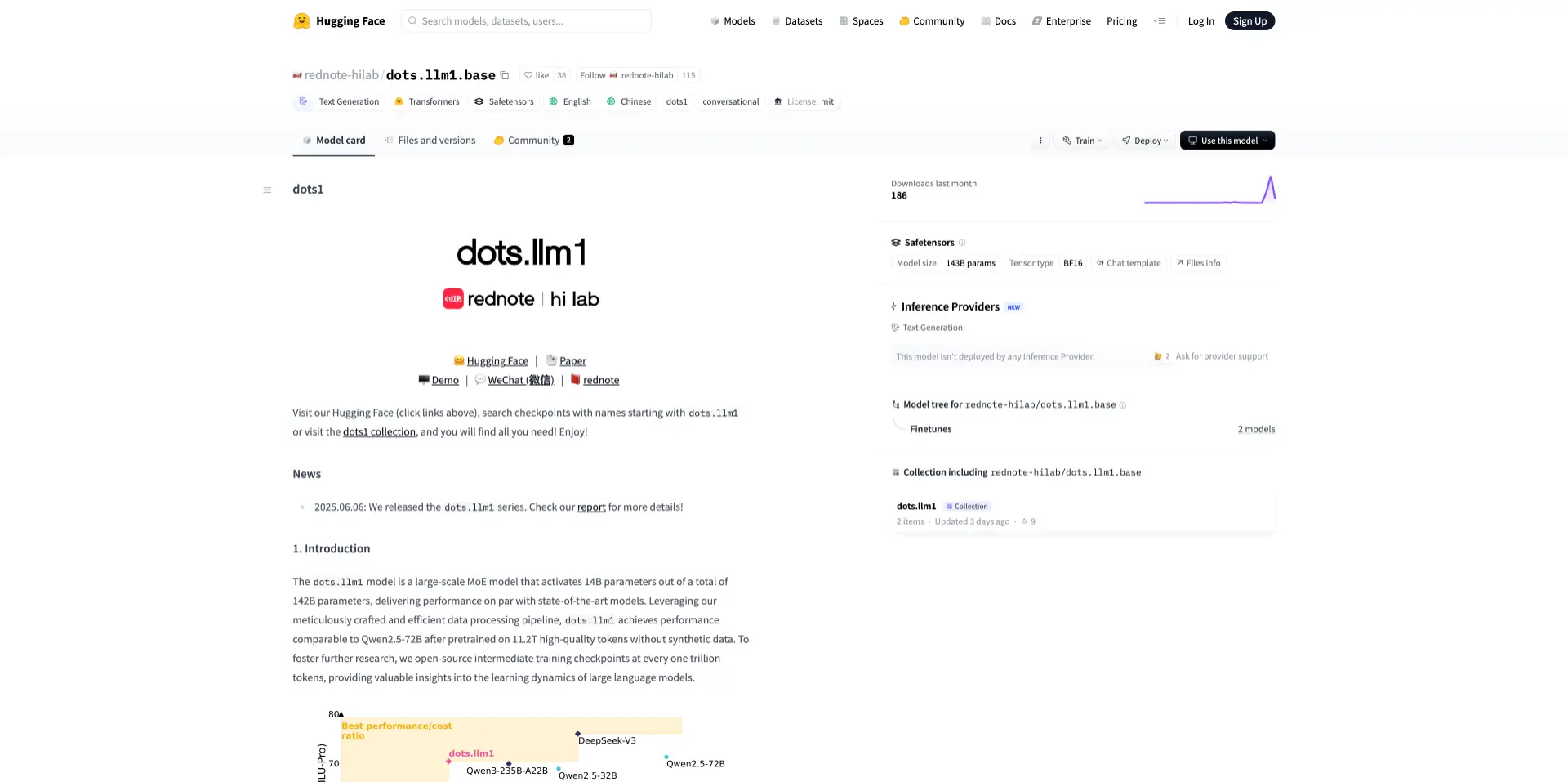

近日,小红书正式开源其首个自研大语言模型 dots.llm1。该模型基于 MoE(专家混合)架构,参数总量为 1420 亿,实际推理中激活 140 亿参数,旨在平衡模型性能与推理效率。

dots.llm1 的预训练数据由 11.2 万亿个非合成 token 构成,覆盖中英文语料,未使用合成数据。模型使用了三阶段数据处理流程,优化数据质量并提升知识分布均衡性。架构上采用多头注意力机制、RMSNorm 归一化和 SwiGLU 激活函数,并配合高效的通信与调度机制。

根据项目公开信息,dots.llm1 在中文语言理解与生成任务中表现良好,支持最长 32K 上下文,适用于问答、文本生成、摘要提取、语义检索等应用场景。为支持研究用途,小红书还开放了每训练 1 万亿 token 的中间检查点。

模型已在 Hugging Face 上开源,包含 base 与 instruction-tuned 两个版本,遵循 MIT 许可证。

开源地址:https://huggingface.co/rednote-hilab/dots.llm1.base

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。