CogAgent-9B 是什么?

CogAgent-9B是由智谱AI最新推出的开源的 GLM-PC 基座模型,基于 GLM-4V-9B 训练而成的专用Agent任务模型。该模型仅需屏幕截图作为输入(无需HTML等文本表征),便能根据用户指定的任意任务,结合历史操作,预测下一步的GUI操作。得益于屏幕截图和GUI操作的普适性,CogAgent 可广泛应用于各类基于GUI交互的场景,如个人电脑、手机、车机设备等。

相较于2023年12月开源的第一版 CogAgent 模型,CogAgent-9B-20241220 在 GUI 感知、推理预测准确性、动作空间完善性、任务普适性和泛化性等方面均实现了显著提升,并支持中英文双语的屏幕截图和语言交互。

CogAgent-9B的核心特点

- 创新输入方式: 仅通过屏幕截图作为输入,不需要任何布局信息或附加元素标签。通过分析截图和历史动作,CogAgent-9B能够高效预测下一步的操作。

- 双语支持: 不仅支持中文和英文的操作界面交互,还能够识别并理解双语屏幕截图,满足全球用户的需求。

- 强大的视觉理解: 基于GLM-4V-9B视觉语言模型,CogAgent-9B具有超强的图像理解能力,能够精确解析图形界面的每个细节,确保预测结果的准确性。

- 广泛适用性: 从个人电脑到手机、车机等多平台设备,CogAgent-9B能在不同设备上执行复杂的GUI任务,适用于各种工作流和应用场景。

- 高效性与精确性: 通过优化的视觉处理模块和高效的输入图像处理方法,CogAgent-9B能够在保证精度的同时,提升任务执行速度。

- 灵活的任务执行: 支持从基础操作(如点击、输入)到高级动作(如启动应用、调用语言模型等)的多种任务执行。通过结构化的自然语言描述和函数调用形式,确保动作执行准确无误。

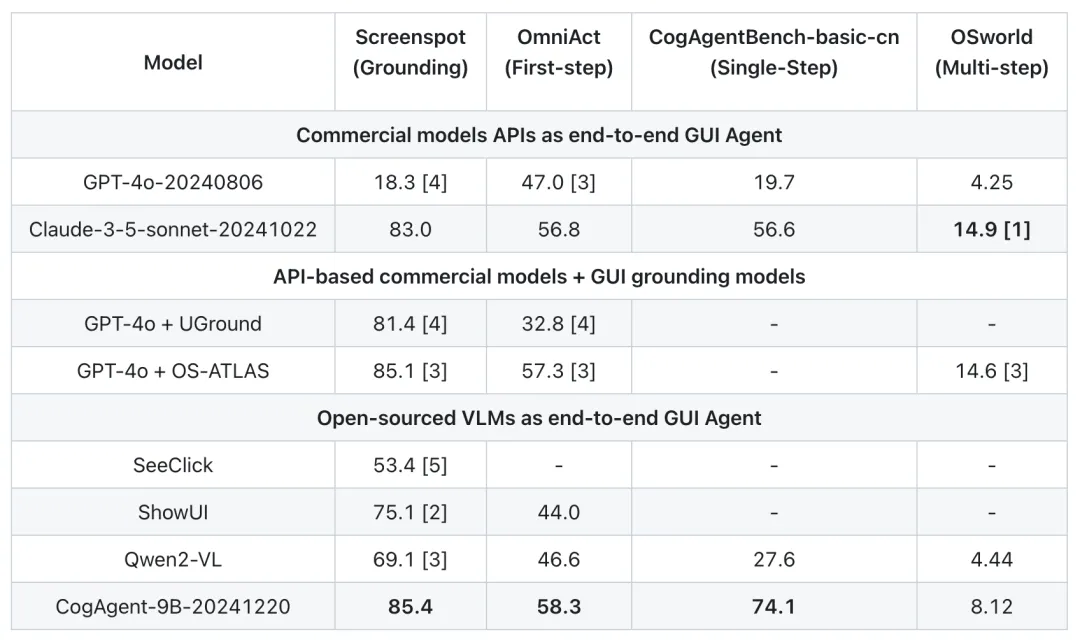

CogAgent-9B 的评测结果

CogAgent-9B 在多个关键性能指标上表现出色,尤其是在 GUI 定位(Screenspot)、单步操作(OmniAct)和中文 step-wise 榜单(CogAgentBench-basic-cn)等方面均取得了领先的成绩。尽管在某些多步操作任务(如 OSWorld)中,CogAgent-9B略逊色于针对计算机使用优化的 Claude-3.5-Sonnet 和结合外接 GUI Grounding 的 GPT-4o,但整体性能仍然非常强劲。

CogAgent-9B的适用场景

- 个人计算机操作: 自动化办公流程、应用程序操作、系统设置等。

- 智能手机交互: 支持多任务处理、应用管理、文件浏览等操作。

- 车载设备: 实现车载系统中信息娱乐、导航和智能助手等多种操作。

- 智能家居设备: 管理智能家居系统、控制设备、设定自动化任务等。

CogAgent-9B相关资源

- 论文: https://arxiv.org/abs/2312.08914

- 代码: https://github.com/THUDM/CogAgent

- 技术文档:https://cogagent.aminer.cn/blog#/articles/cogagent-9b-20241220-technical-report

- 模型:

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。