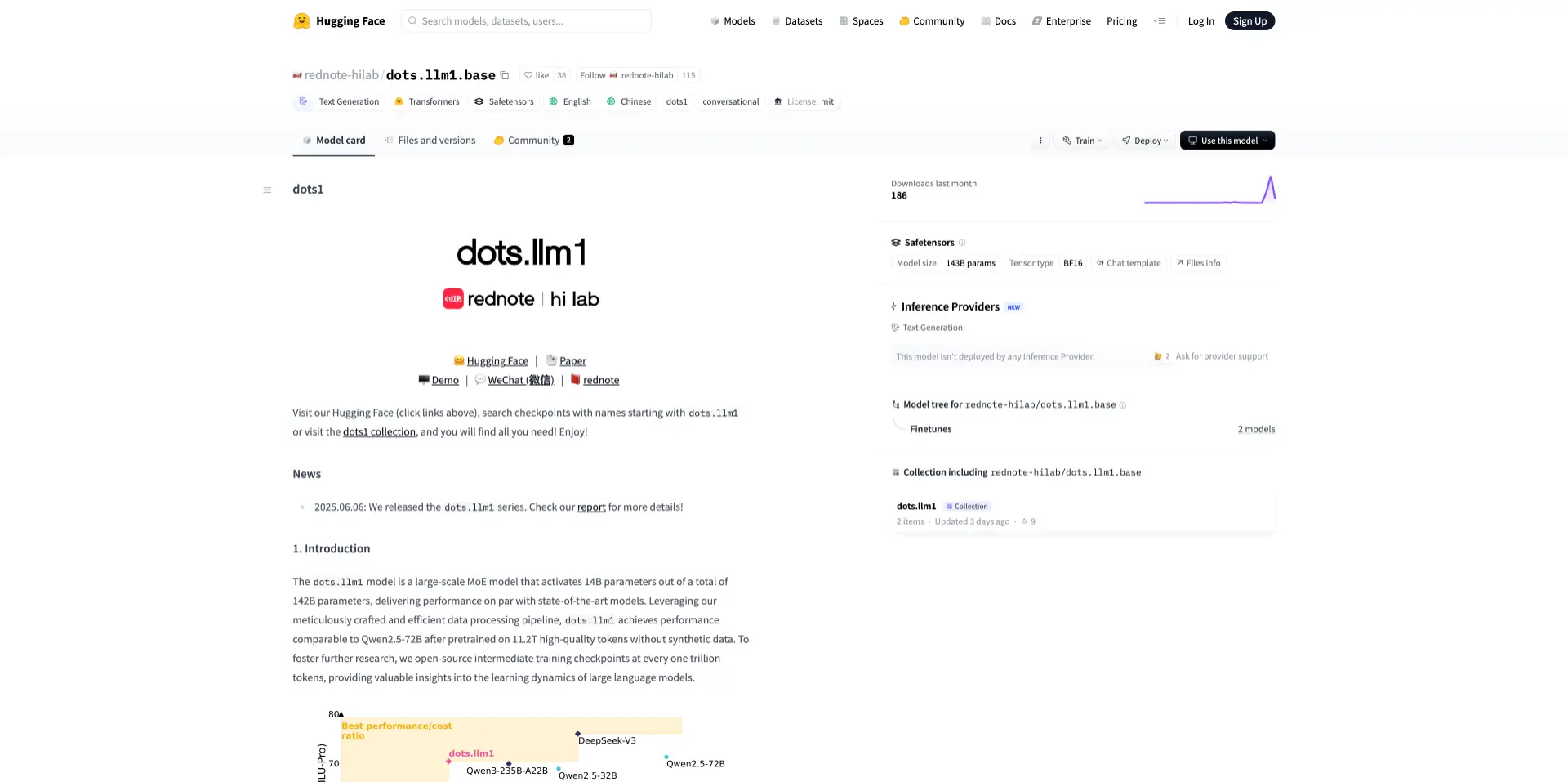

dots.llm1是什么?

dots.llm1 是小红书开源的 MoE 架构大语言模型,拥有 1420 亿参数,推理仅激活 140 亿,兼顾性能与效率。模型基于 11.2 万亿非合成高质量数据训练,支持中英文,具备 32K 长上下文处理能力,并开放中间训练 checkpoint,适合问答、内容生成、语义理解等多种应用场景。

在中文基准测试中,dots.llm1 的综合得分(如 MMLU、CMMLU、CEval 等)超过 DeepSeek V2/V3、阿里 Qwen2.5-32B/72B 等主流开源模型,显示出在中文理解与生成任务上的强竞争力。

dots.llm1 的模型亮点

- 稀疏激活、高效架构:总参数 1420 亿,但每次推理仅激活 140 亿参数,基于 MoE 架构,有效平衡计算性能与推理效率。

- 超大规模非合成训练数据:预训练使用了 11.2 万亿 token 的非合成高质量数据,无人工合成数据介入,内容更加自然真实。

- 先进的工程优化设计:采用创新的 all-to-all 通信与计算重叠技术(基于 1F1B 流水线与 Grouped GEMM 实现),提升大模型部署效率。

- 更强的数据处理能力:内建 三级高精度数据清洗流程,生成多样性强、质量高的预训练语料,支持中英文双语。

- 上下文窗口大:支持最长 32K tokens 的上下文长度,可处理更长文本,适合长文生成与复杂推理任务。

- 开放的中间训练检查点:每训练 1 万亿 token 开源一次 checkpoint,支持研究者深入了解大模型学习动态。

- 多语言支持:原生支持 中文与英文,模型语义能力具有跨语种适应性。

- 开源与商业友好协议:采用 MIT 许可证,便于学术研究与商业使用。

dots.llm1 的应用场景

- 智能问答系统:构建多轮对话型助手与知识问答平台,适用于客服、电商、教育等场景。

- 自动摘要生成:为资讯、法律、医疗等领域快速提炼文档核心内容,提升信息处理效率。

- 内容创作与编辑协同:生成社交媒体文案、营销文本、脚本等,适合内容创作者与品牌方使用。

- 搜索增强与语义检索:改善搜索精准度与个性化体验,适用于电商平台、知识库等系统。

- AI 辅助写作与翻译:在教育、出版、商业写作中提供语言润色、多语翻译与写作建议。

- 企业知识管理与问答:助力企业构建内部文档智能检索与员工问答系统,提升运营效率。

- 教学与学术研究辅助:用于智能出题、答题、模型分析等,支持教育产品与科研探索。

dots.llm1 的项目地址

- 在线体验:https://huggingface.co/spaces/rednote-hilab/dots-demo

- 模型地址:https://huggingface.co/rednote-hilab/dots.llm1.base/tree/main

- 技术报告:https://github.com/rednote-hilab/dots.llm1/blob/main/dots1_tech_report.pdf

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。