Qwen2是什么?

Qwen2是阿里云通义千问团队开源的新一代大语言模型,推出了5个尺寸的预训练和指令微调模型,在中文英语的基础上,训练数据中增加了27种语言相关的高质量数据;代码和数学能力显著提升;增大了上下文长度支持,最高达到128K tokens(Qwen2-72B-Instruct)。多个评测基准上的领先表现。现已在Hugging Face和ModelScope开源。

Qwen2系列包含5个尺寸的预训练和指令微调模型,其中包括Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B和Qwen2-72B。如下表所示:

| 模型 | Qwen2-0.5B | Qwen2-1.5B | Qwen2-7B | Qwen2-57B-A14B | Qwen2-72B |

|---|---|---|---|---|---|

| 参数量 | 0.49B | 1.54B | 7.07B | 57.41B | 72.71B |

| 非Embedding参数量 | 0.35B | 1.31B | 5.98B | 56.32B | 70.21B |

| GQA | True | True | True | True | True |

| Tie Embedding | True | True | False | False | False |

| 上下文长度 | 32K | 32K | 128K | 64K | 128K |

Qwen2的亮点特性

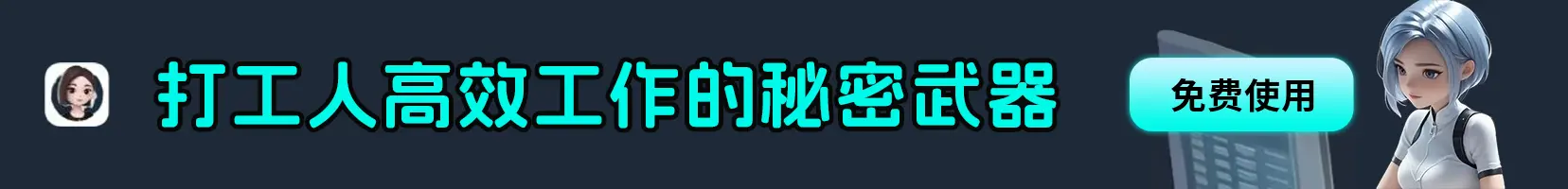

1、代码 & 数学:在代码方面,Qwen2实现了在多种编程语言上的显著效果提升。而在数学方面,大规模且高质量的数据帮助Qwen2-72B-Instruct实现了数学解题能力的飞升。

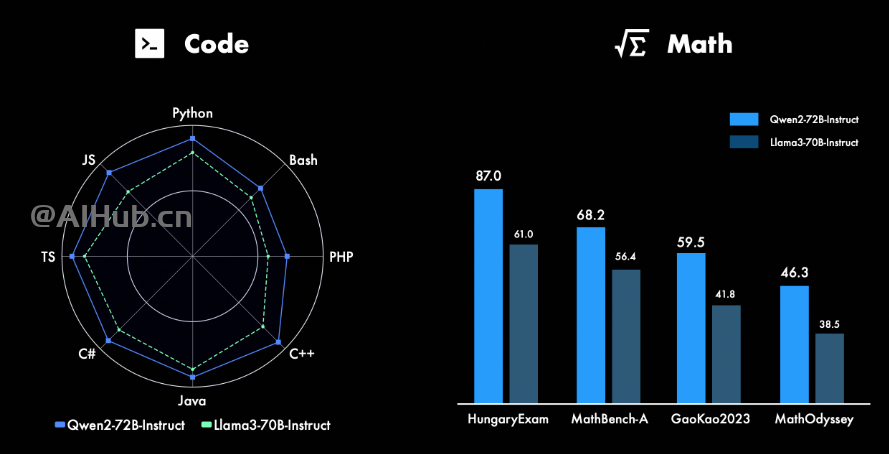

2、长文本处理:Qwen2-7B-Instruct几乎完美地处理长达128k的上下文;Qwen2-57B-A14B-Instruct则能处理64k的上下文长度;而该系列中的两个较小模型则支持32k的上下文长度。

3、安全方面:通过显著性检验(P值),Qwen2-72B-Instruct模型在安全性方面与GPT-4的表现相当,并且显著优于Mistral-8x22B模型。

Qwen2的性能评测

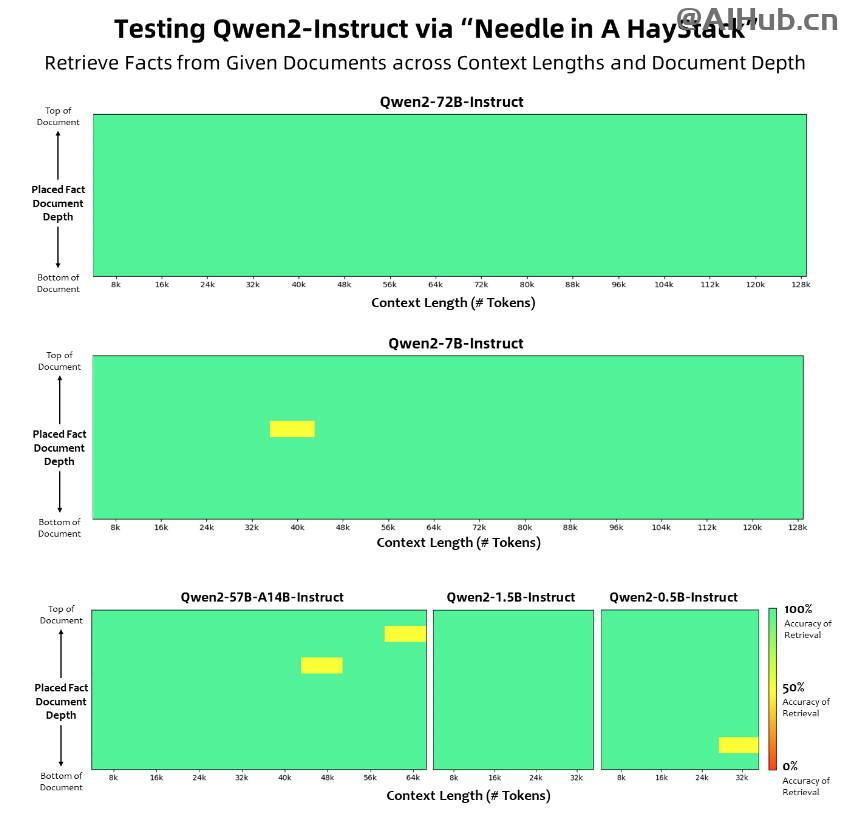

相比Qwen1.5,Qwen2在大规模模型实现了非常大幅度的效果提升。在针对预训练语言模型的评估中,对比当前最优的开源模型,Qwen2-72B在包括自然语言理解、知识、代码、数学及多语言等多项能力上均显著超越当前领先的模型,如Llama-3-70B以及Qwen1.5最大的模型Qwen1.5-110B。

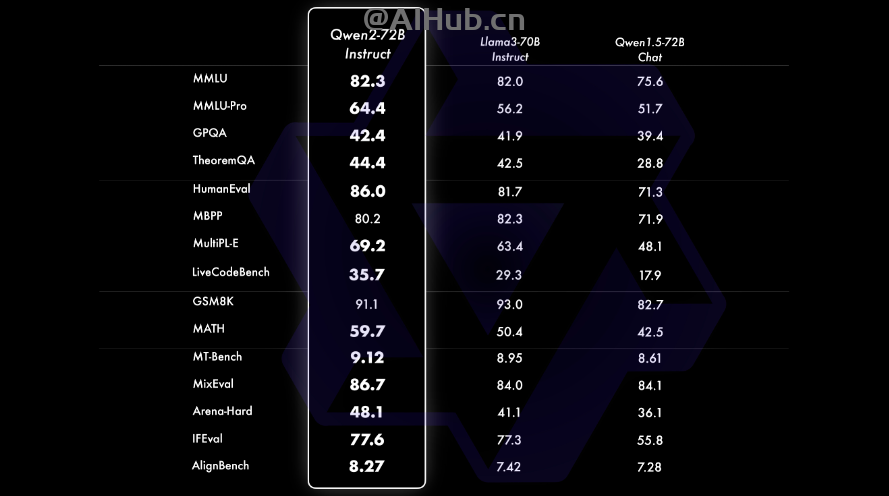

Qwen2-72B-Instruct在提升基础能力以及对齐人类价值观这两方面取得了较好的平衡。相比Qwen1.5的72B模型,Qwen2-72B-Instruct在所有评测中均大幅超越,并且了取得了匹敌Llama-3-70B-Instruct的表现。

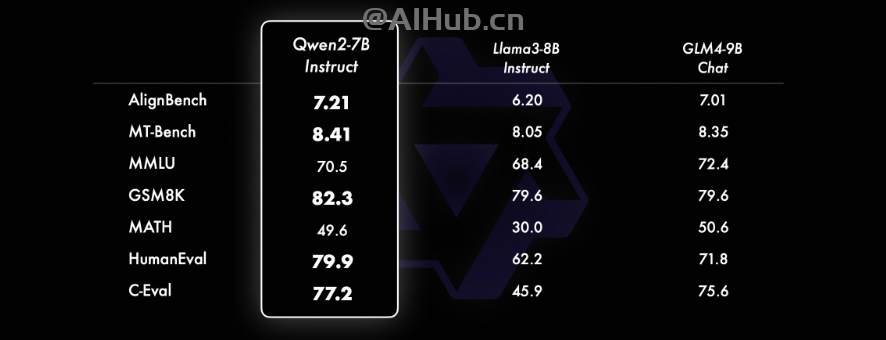

在小模型方面,Qwen2系列模型基本能够超越同等规模的最优开源模型甚至更大规模的模型。相比近期推出的最好的模型,Qwen2-7B-Instruct依然能在多个评测上取得显著的优势,尤其是代码及中文理解上。

如何使用Qwen2?

目前,Qwen2已在Hugging Face和ModelScope上同步开源,相关资源地址如下:

- Qwen2项目博客:https://qwenlm.github.io/zh/blog/qwen2

- 在线体验地址:https://huggingface.co/spaces/Qwen/Qwen2-72B-Instruct

- GitHub地址:https://github.com/QwenLM/Qwen2

- Hugging Face模型地址:https://huggingface.co/Qwen

- ModelScope模型地址:https://modelscope.cn/organization/qwen

阿里云基于Qwen2的AI编程助手通义灵码正式上线,如有兴趣,可以试试。