Qwen3-Coder 提供多种尺寸,此前开源了顶配版Qwen3-Coder-480B-A35B-Instruc,今天又开源了轻量版本Qwen3-Coder-Flash,全称为Qwen3-Coder-30B-A3B-Instruct。

Qwen3-Coder-Flash是什么?

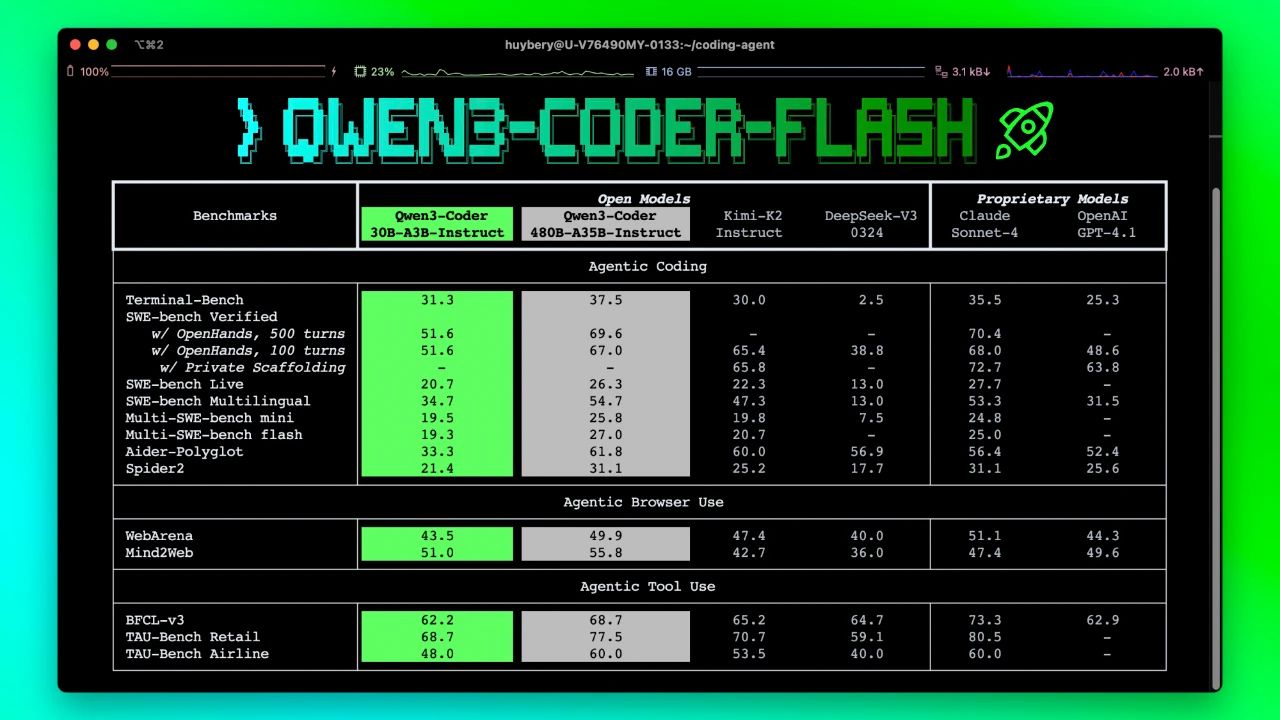

Qwen3-Coder-Flash 是阿里通义千问开源的 30B 参数编程大模型。Qwen3-Coder-Flash拥有超强的Agent能力,在代理式编程(Agentic Coding)、浏览器使用(Agentic Browser-Use)、工具调用(Tool Use)等领域,超越当前顶级开源模型,仅略逊于顶配版Qwen3-Coder-480B-A35B-Instruct,及Claude Sonnet-4、GPT4.1等领先闭源模型。

该模型支持 256K tokens 原生上下文长度,并可通过 YaRN 技术扩展至 最多 1M tokens,显著提升长上下文处理能力。它还针对 Qwen Code、CLINE、Roo Code 等平台进行了 函数调用格式优化,提升实际部署效率。

模型权重已在 ModelScope 与 Hugging Face 平台开放下载,并可通过 Qwen Chat 在线体验。

Qwen3-Coder-Flash的主要特性

- 卓越的Agentic能力:Qwen3-Coder-Flash拥有超强的Agent能力。在代理式编程(Agentic Coding)、浏览器使用(Agentic Browser-Use)、工具调用(Tool Use)等领域,超越当前顶级开源模型,仅略逊于顶配版Qwen3-Coder-480B-A35B-Instruct,及Claude Sonnet-4、GPT4.1等领先闭源模型。

- 仓库级长上下文理解:原生支持 256K tokens,支持 YaRN 可扩展至 1M tokens,整个项目库都能理解,再也不用担心代码上下文断层了。

- 支持多平台使用:具备专门设计的函数调用格式,为Qwen Code、CLINE、Roo Code、Kilo Code等平台作了优化,用起来超顺手。

如何体验Qwen3-Coder-Flash?

Qwen3-Coder-Flash已在魔搭社区、Hugging Face正式开源,开发者可在本地硬件自由部署。同时,也在 Qwen Chat 上同步上线了新模型。

- 在线体验:chat.qwen.ai

- 开源模型:

©版权声明:如无特殊说明,本站所有内容均为AIHub.cn原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。