-

Stable Virtual Camera:Stability AI等推出的AI模型 ,2D图像轻松转3D视频

Stable Virtual Camera是由Stability AI推出的多视图扩散模型,能够将2D图像转化为具有真实深度和透视效果的3D视频。该模型支持用户自定义相机轨迹和多种动态路径,可从单个或多达32个输入图像生成3D视频,并支持多种宽高比和长达1000帧的长视频生成。 -

-

天镜大模型-国内首个零售金融大模型

“天镜”寓意大模型是人类智慧的镜像,“天镜”大模型汇集智慧、唤醒知识、众创价值和数字分身。在汇集智慧场景下,“天镜”可整合一线客服人员服务经验,实现一对多服务客户。在唤醒知识场景下,可解析专业金融文件,进行多文档查询和数据分析。 -

Moonlight - 月之暗面推出的开源MOE模型

Moonlight 是由月之暗面公司推出的开源 MoE(Mixture of Experts)语言模型,,使用 Muon 优化器训练,激活参数仅需 3B。该模型在训练效率和性能上表现出色,训练 FLOPs 明显减少,同时支持 64K 上下文处理能力。它适用于多种自然语言处理任务,包括语言理解和生成。 -

-

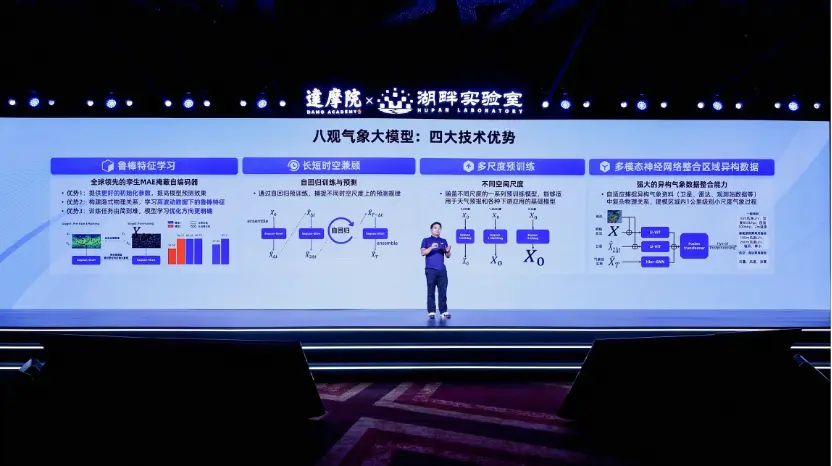

八观气象大模型 - 阿里达摩院推出的高精度气象预测模型,重点指标超过传统天气预报

八观气象大模型是阿里巴巴达摩院推出的高精度气象预测模型,专注于通过整合全球和区域多源数据来提供精准的天气预报。该模型将AI技术应用于气象预测领域,为新能源、电力调控等行业提供更具时效性和高分辨率的天气数据支持。 -

GPT-4-OpenAI旗下AI大模型

GPT-4是OpenAI的大型语言模型的最新版本。它在各种各样的互联网文本上进行了训练,但也从其他各种来源学习。因此,它能够以对话的方式生成富有创造性、连贯性和与上下文相关的句子。 -

ReALM-苹果推出的AI系统,可「看懂」屏幕内容并语音回复

ReALM是苹果公司开发的一款新型人工智能AI系统,能够解析并理解屏幕上的内容,提供自然的语音助手交互。利用大语言模型技术,ReALM将视觉识别任务转换为语言处理问题,优化了性能并提升了文本表示的准确性。 -

DeepSeek-R1:深度求索发布的AI推理模型,性能对标 OpenAI o1 正式版

DeepSeek-R1 是深度求索推出的高性能推理模型,性能与 OpenAI o1 正式版相当。通过强化学习技术和极少标注数据,DeepSeek-R1 在数学、代码和自然语言推理等任务中表现卓越。该模型遵循 MIT License 开源,支持模型蒸馏,允许用户训练其他模型。此外,DeepSeek-R1 提供 API 服务,按 token 计费,广泛应用于科研、技术开发和企业智能化升级等领域。 -

Qwen2.5-Coder:阿里巴巴推出的开源代码生成模型

Qwen2.5-Coder是由阿里巴巴最新推出的开源代码生成模型,本次一共有0.5B、3B、14B和32B四个版本,Qwen2.5-Coder 支持40多种编程语言的模型,能够处理多种编程任务,尤其在代码生成、修复和推理方面具有显著优势。 -

Step-Video-T2V:阶跃星辰推出的开源视频生成大模型

Step-Video-T2V是阶跃星辰与吉利联合开源的一款高性能视频生成大模型,具备300亿参数量,能够生成540P分辨率的高质量视频。它支持复杂运动场景、精准镜头控制和生动人物生成,能够根据文本输入生成符合物理规律的视频。 -

Gemini 2.5 Flash:Google 推出的首个完全混合推理模型

Gemini 2.5 Flash 是 Google 推出的首个完全混合推理模型,允许开发人员灵活控制模型的思考功能,可开启或关闭。它还支持设置思考预算,帮助开发者在质量、成本和延迟之间找到最佳平衡。即使关闭思考功能,模型仍能保持 2.0 Flash 的高速度,并进一步提升性能,兼具高效推理和成本效益。目前处于预览阶段,支持通过 API 在 Google AI Studio 和 Vertex AI … -

-

-

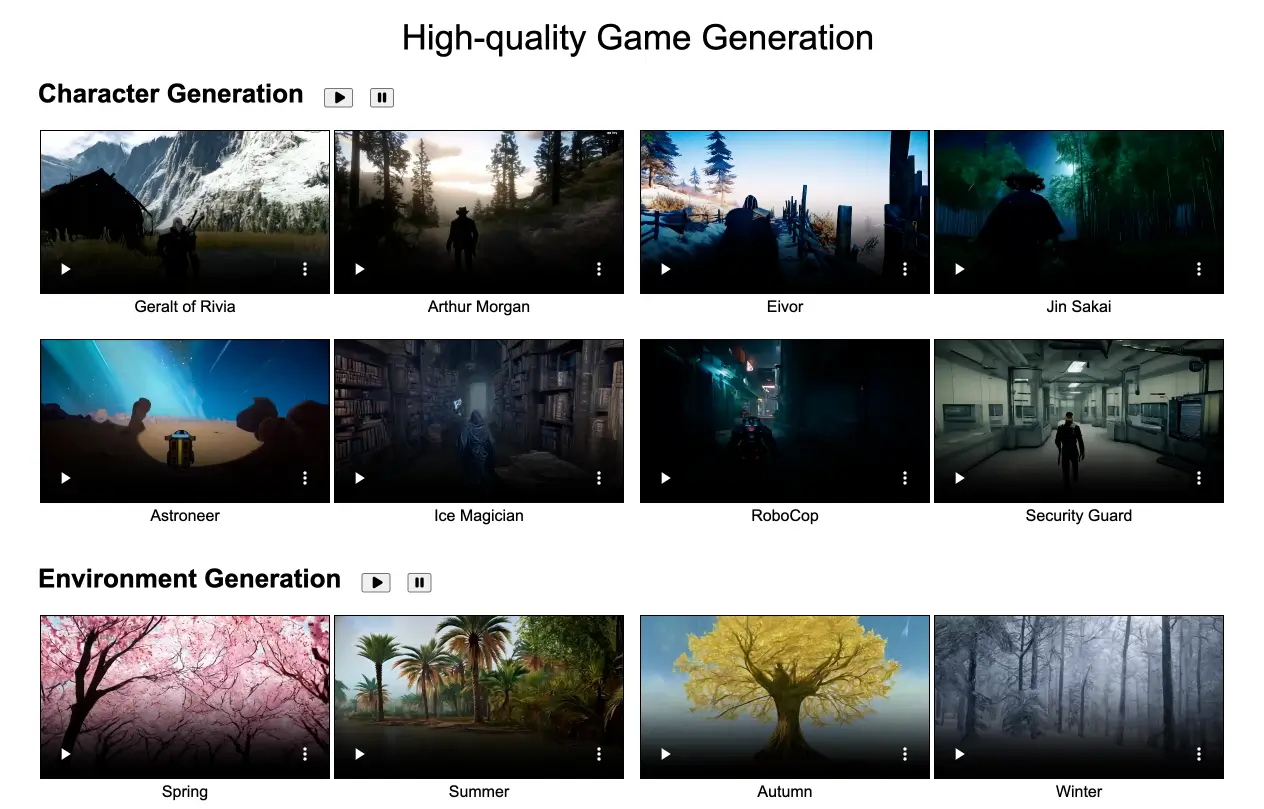

GameGen-O:腾讯推出的视频游戏生成模型,支持生成角色、环境和动作等

GameGen-O是腾讯推出的一款专门用于生成开放世界视频游戏的AI模型,它能够模拟游戏引擎功能,生成游戏角色、动态环境、复杂动作和事件,并支持互动控制。用户可以通过文本、操作信号和视频提示来实时控制游戏内容。GameGen-O 的推出标志着游戏开发进入了AI辅助的新阶段,简化了许多复杂的开发环节,降低了开发成本,甚至让普通用户也能轻松生成高质量的游戏内容。 -

Skywork R1V:昆仑万维开源的多模态视觉思维链推理模型

Skywork R1V 是昆仑万维开源的多模态视觉思维链推理模型,专注于通过多步逻辑推理解决复杂的视觉任务。它结合了强大的文本推理能力和视觉理解能力,能够处理视觉逻辑推理、数学问题、科学现象分析等任务。 -

-

Hunyuan-Large:腾讯最新开源的MoE大模型,效果业界领先

由腾讯开发的开源业界参数规模最大、效果最好的transformer结构的 MoE 模型,在公开benchmark、多轮对话、高质量文本生成、数学逻辑、代码创作等多个任务上具有优异效果 -

Emu2:智源研究院开源发布的新一代生成式多模态基础模型

2023年12月21日,智源研究院发布了新一代多模态基础模型 Emu2。Emu2通过大规模自回归生成式多模态预训练,显著推动了多模态上下文学习能力的突破。 Emu2在少样本多模态理解任务上表现出色,超越了主流多模态预训练大模型 Flamingo-80B 和 IDEFICS-80B。在 VQAv2、OKVQA、MSVD、MM-Vet、TouchStone 等多个少样本理解、视觉问答、主体驱动图像生成… -

Yi大模型-零一万物发布的开源大模型

Yi系列模型是由来自“零一万物”的开发者研发的大型语言模型。第一个公开版本包含两个双语版(英语/中文)基础模型,参数规模分别为6B和34B。两者都使用4K序列长度进行训练,并在推理时可以扩展到32K。 -

-

ThinkSound - 阿里通义开源的AI音频生成模型

ThinkSound 是阿里通义实验室开源的首个音频生成模型,能够像专业音效师一样理解画面内容并进行结构化推理,从而生成高保真、与视觉高度同步的空间音频,适用于影视、短视频、游戏等多种创作场景。 -

Qwen2-VL:阿里最新开源的视觉多模态大语言模型

Qwen2-VL是由阿里巴巴最新开源的视觉多模态大语言模型系列,专注于视觉语言的理解和处理。该模型能够处理不同分辨率和比例的图像,并具备对20分钟以上视频内容的理解能力。测试数据显示,其72B模型在大多数指标上超过了OpenAI的GPT-4o和Anthropic的Claude3.5-Sonnet等知名闭源模型,成为目前最强的多模态模型之一。 -

-

-

协和·太初 - 北京协和医院和中科院联合推出的罕见病领域 AI 大模型

“协和・太初”是由北京协和医院和中国科学院自动化研究所共同研发的国内首个罕见病领域 AI 大模型。该模型基于我国罕见病知识库的多年积累和中国人群基因检测数据,是国际首个符合中国人群特点的罕见病大模型。 -

HAI-腾讯云AI应用开发平台

腾讯云HAI是一款面向AI、科学计算的GPU应用服务产品,提供即插即用的澎湃算力与常见环境。助力中小企业及开发者快速部署LLM、AI作画、数据科学等高性能应用,原生集成配套的开发工具与组件,大幅提高应用层的开发生产效率。可帮你在10分钟内开发专属AI应用。 -

用友YonGPT:首个企业服务大模型

7月27日,用友发布业界首个企业服务大模型YonGPT。YonGPT是用友商业创新平台“用友BIP”的重要组成部分,能够底层适配业界主流的通用语言大模型,通过提供通用能力服务、领域服务及行业服务,实现业务运营、人机交互、知识生成、应用生成等四个方面的企业智能化应用。 -

华为-盘古AI大模型

根据华为云官网消息,华为旗下的盘古系列AI大模型即将上线,该系列AI大模型中的NLP大模型、CV大模型、科学计算大模型(气象大模型)已经标记为即将上线状态。 据悉,盘古大模型采用了深度学习和自然语言处理技术,并使用了大量的中文语料库进行训练。该模型拥有超过1千亿个参数,可以支持多种自然语言处理任务,包括文本生成、文本分类、问答系统等等。 其中,盘古NLP大模型是被认为最接近人类中文理解能力的AI大… -

-

华知大模型-同方知网携手华为推出的中华知识大模型

华知大模型是同方知网携手华为共同打造内容权威可信、全栈自主可控的专注于知识服务与科研行业的中华知识大模型,旨在覆盖政企文教等多个行业场景,并提供30多项通用能力体系。 -

-

-

-

LivePhoto:图片生成动态视频模型

阿里巴巴、香港大学、蚂蚁集团的研究人员提出了一种全新图片生成动态视频模型——LivePhoto。用户通过LivePhoto,可将一张静态图片快速生成高精准的动态视频。 与传统方法不同的是,LivePhoto在开源文生图模型Stable Diffusion基础之上,增加了运动强度和文本加权两大创新模块,可精准掌控动态视频生成过程中的运动强度、文本描述。研究人员将LivePhoto与主流模型Gen-2… -

AgentVerse-一个用于搭建多智能体交互平台的框架

AgentVerse 提供了一个多功能的框架,简化了为大型语言模型(LLMs)创建自定义多智能体环境的过程。旨在快速、低成本的开发和定制,我们的框架赋能研究人员专注于他们的研究,而不被实现细节所困扰。 -

千影 QianYing:巨人网络推出的有声游戏生成大模型

千影 QianYing 是巨人网络发布的有声游戏生成大模型,结合了 YingGame(游戏视频生成)和 YingSound(视频配音)两大核心技术,旨在通过人工智能大幅提升游戏内容的生成效率和创作自由度。它支持通过简单的文字描述生成游戏视频、音效及互动内容,降低游戏开发门槛,推动“游戏+AI”深度融合,为游戏开发、教育培训、内容创作等多个领域提供创新解决方案。 -

天幕大模型-万兴科技发布的多媒体AI大模型

“天幕” 多媒体大模型将以视频、绘图、文档等数字创意软件业务场景为依托,为创作者提供更专业化的 AI 创新解决方案。它涵盖了视觉、音频、语言等多模态 AI 生成和优化的能力,具备一键成片、AI 美术设计、文生音乐、音频增强、音效分析、多语言对话等核心功能。 -

美图发布 7 款影像生产力工具,推出视觉大模型

6 月 19 日消息,美图公司举办以“AI 时代的影像生产力工具”为主题的第二届影像节,现场发布 7 款新品:AI 视觉创作工具 WHEE;AI 口播视频工具开拍;桌面端 AI 视频编辑工具 WinkStudio;主打 AI 商业设计的美图设计室 2.0;AI 数字人生成工具 DreamAvatar;美图 AI 助手 RoboNeo;美图视觉大模型 MiracleVision。 IT之家从美图官方… -

昆仑万维-天工AI大模型

天工作为一款大型语言模型,拥有强大的自然语言处理和智能交互能力,能够实现智能问答、聊天互动、文本生成等多种应用场景,并且具有丰富的知识储备,涵盖科学、技术、文化、艺术、历史等领域。